Create Kinesis Data Firehose Delivery Stream

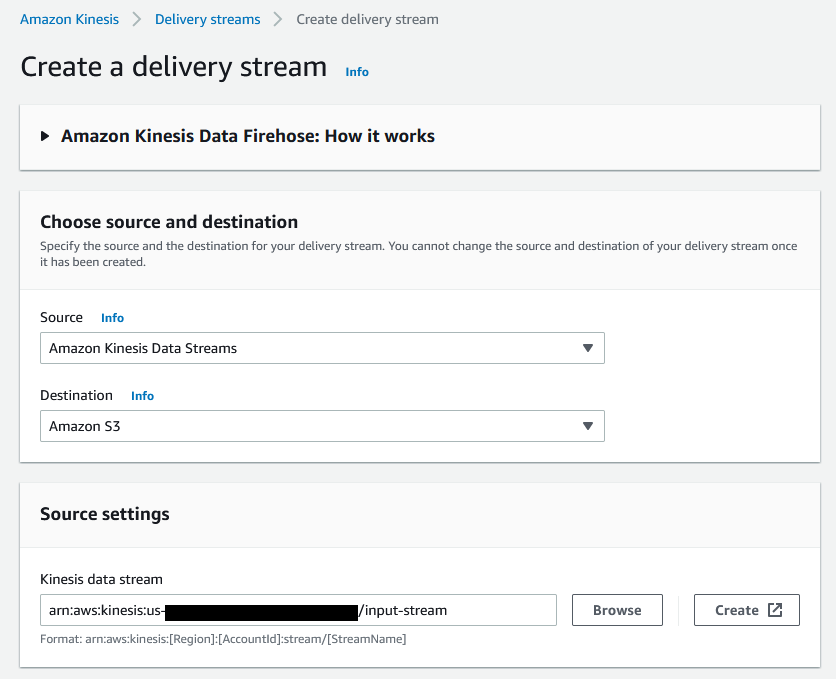

이 섹션에서는 Kinesis Data Stream에서 뉴욕시 택시 운행 데이터를 불러오는데 사용할 새로운 Kinesis Data Firehose Delivery Stream을 생성합니다.

1. AWS 관리 콘솔에서 Amazon Kinesis 서비스로 이동합니다 .

2. Create delivery stream을 선택합니다.

3. Source에 Amazon Kinesis Data Stream을 선택합니다. Destination에 Amazon S3를 선택합니다.. Browse 버튼을 클릭하면 나오는 Kinesis Data Stream 목록에서 input-stream을 선택합니다.

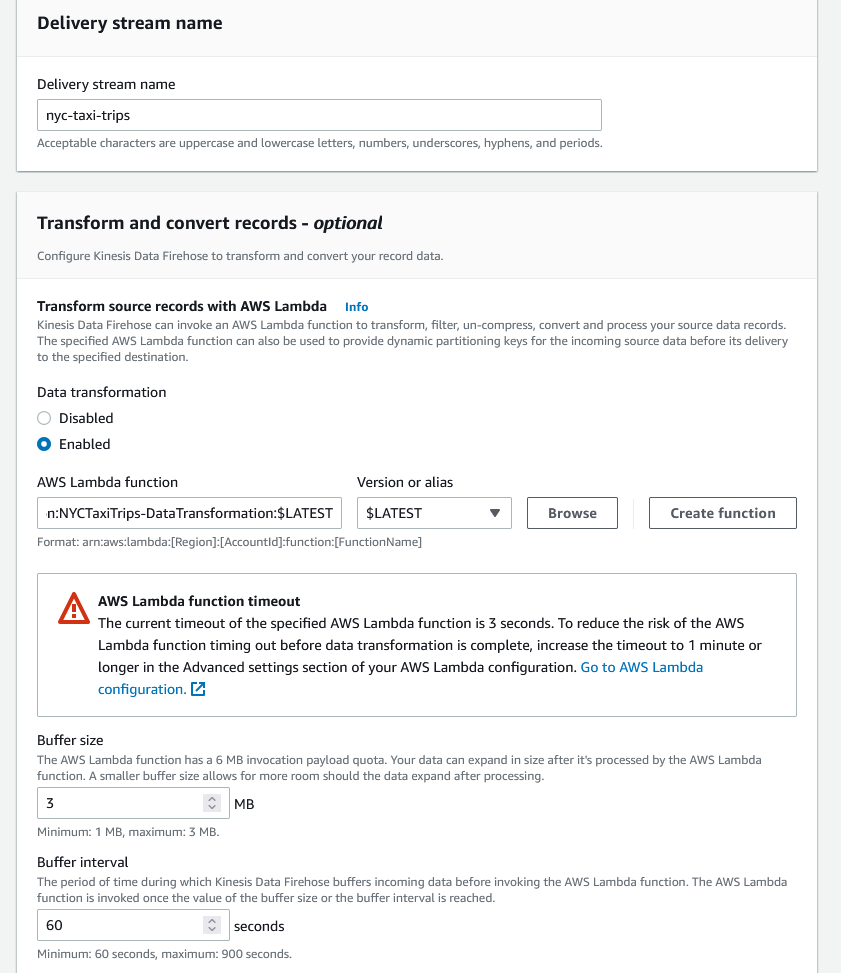

4. Delivery Stream 이름에 nyc-taxi-trips 입력합니다. Data transformation를 Enabled로 선택하고 Browse를 클릭해서 NYCTaxiTrips-DataTransformation 람다 함수를 선택합니다. 해당 람다 함수는 수신한 데이터에 source 필드를 추가하고 해당 필드의 값을 NYCTAXI로 지정합니다.

5. Record format conversion을 Enabled로 선택하고 Output format을 Apache Parquet으로 선택합니다. AWS Glue region에 Asia Pacific (Seoul)을 선택하고 AWS Glue database에 kinesislab을 선택합니다. AWS Glue table는 이전 섹션에서 생성한 nyctaxitrips를 선택합니다.

6. S3 Bucket 오른쪽에 있는 Browse를 클릭해서 kinesis-bucket으로 시작하는 S3 버킷을 선택합니다.

S3 bucket prefix에 아래의 값을 복사하여 붙여 넣습니다.

S3 bucket error output prefix에 아래의 같은 복사하여 붙여 넣습니다.

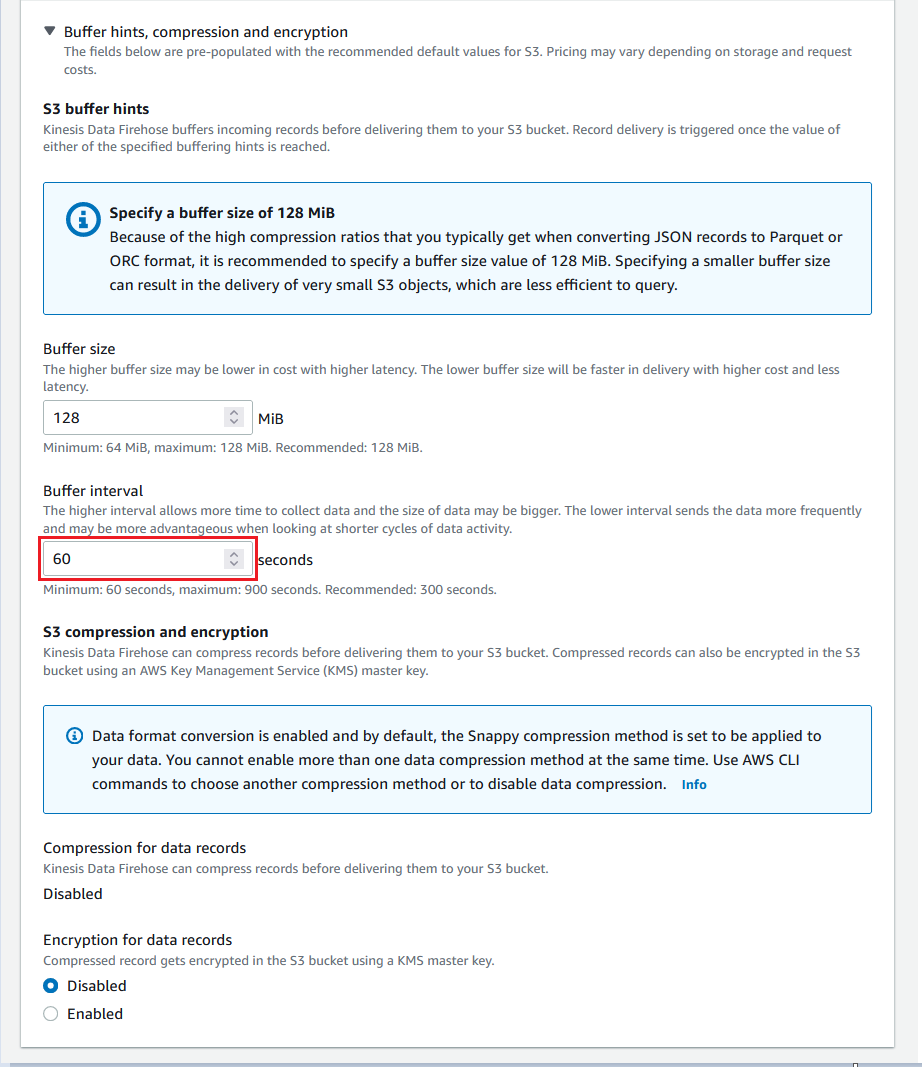

7. Buffer interval을 60초 변경합니다.

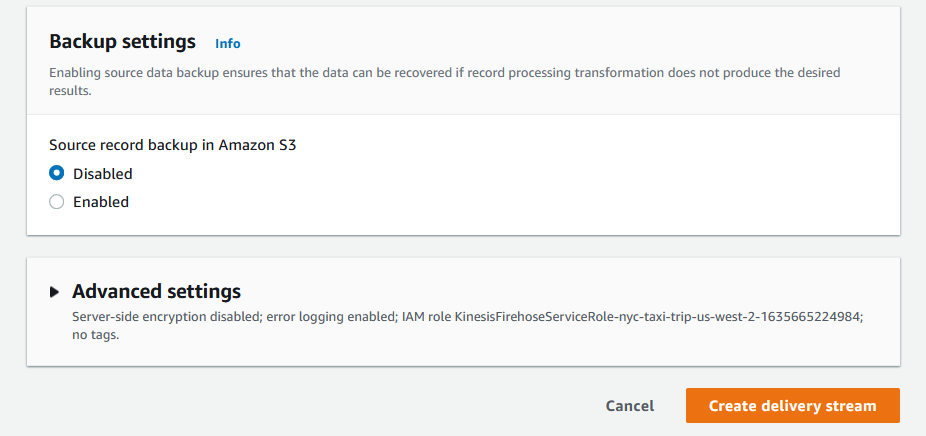

8. Create delivery stream을 클릭합니다.

Last updated