Overview

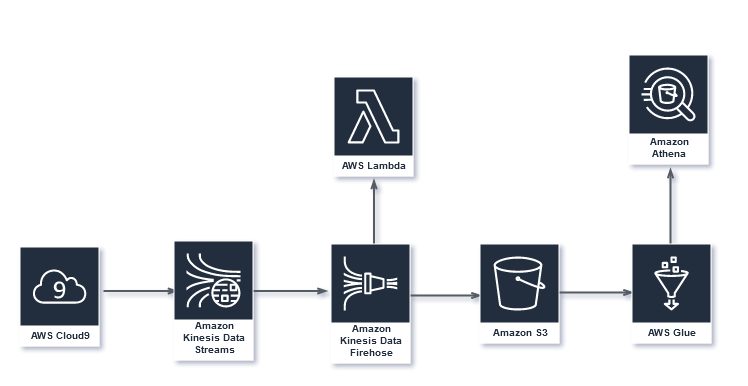

해당 실습에서는 Kinesis Data Stream을 생성하고 Amazon Kinesis Data Firehose Delivery Stream과 연동해서 데에터를 S3 버킷에 저장하는 Data Pipeline을 구축할 것입니다. 또한 Lambda 함수를 생성해서 Kinesis Data Firehose에서 수집된 데이터를 사용자가 원하는 형식으로 변환하는 작업도 추가할 예정입니다.

Amazon Kinesis Data Firehose를 통해서 스트리밍 데이터를 데이터 스토어 및 분석 도구에 전달할수 있습니다. 스트리밍 데이터를 수집 및 변환해서 Amazon S3, Amazon Redshift, Amazon OpenSearch Service 등의 AWS 서비스들 및 Splunk, Datadog 등의 상용솔루션등에 데이터를 전달할수 있습니다. 뿐만 아니라 사용자 지정 HTTP 엔드포인트로도 데이터 전달이 가능해서 기존에 사용 중인 비즈니스 인텔리전스 도구 및 대시보드를 연동해서 실시간(near-realtime)으로 데이터 분석할 수 있습니다. 데이터 처리량에 맞게 자동으로 확장되며 지속적인 관리가 필요하지 않은 완전 관리형 서비스입니다. 또한 데이터를 전달하기 전에 일괄 처리, 압축 및 암호화하여 전달 대상에서 사용되는 스토리지의 양을 최소화하고 보안을 강화할 수 있습니다.

해당 실습에서는 Kinesis Firehose Delivery Stream이 수집한 데이터를 Parquet 파일 형식으로 S3에 저장합니다. Parquet 파일에는 스키마가 정의되어 있으므로 이 실습을 위한 리소스를 생성하는 과정에서 Glue 및 Athena를 사용하여 택시 이동 데이터 세트에 대한 스키마를 정의할 것입니다(Firehouse가 데이터를 S3에 전달하면 데이터를 쉽게 쿼리할 수 있음).

Last updated